當前位置:首頁 > 產(chǎn)品中心 > > 情緒與生理記錄 > ErgoLAB Emotion面部表情分析模塊

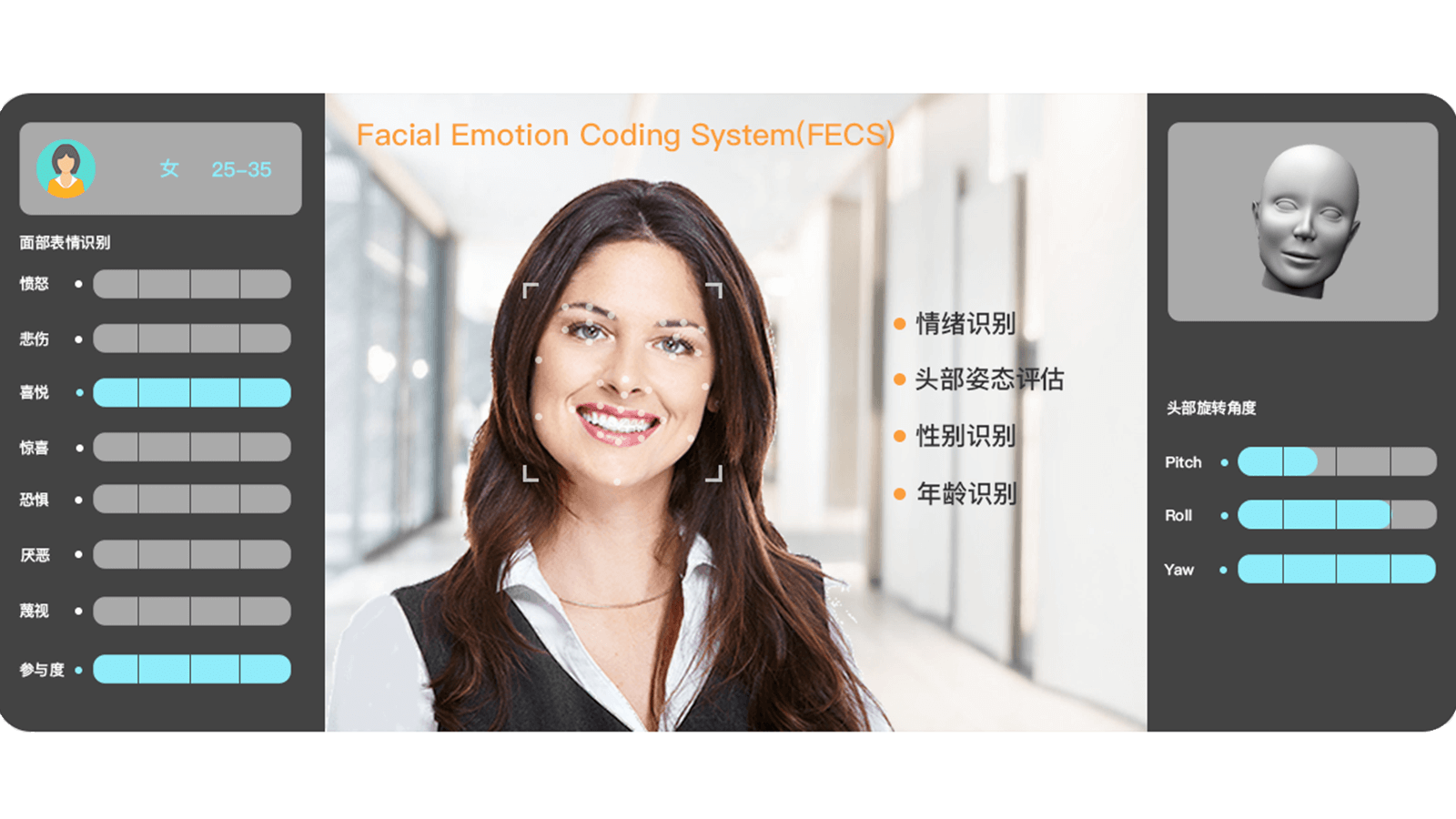

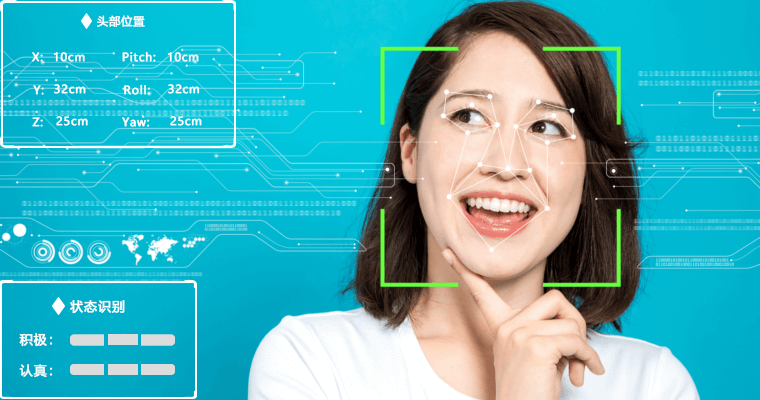

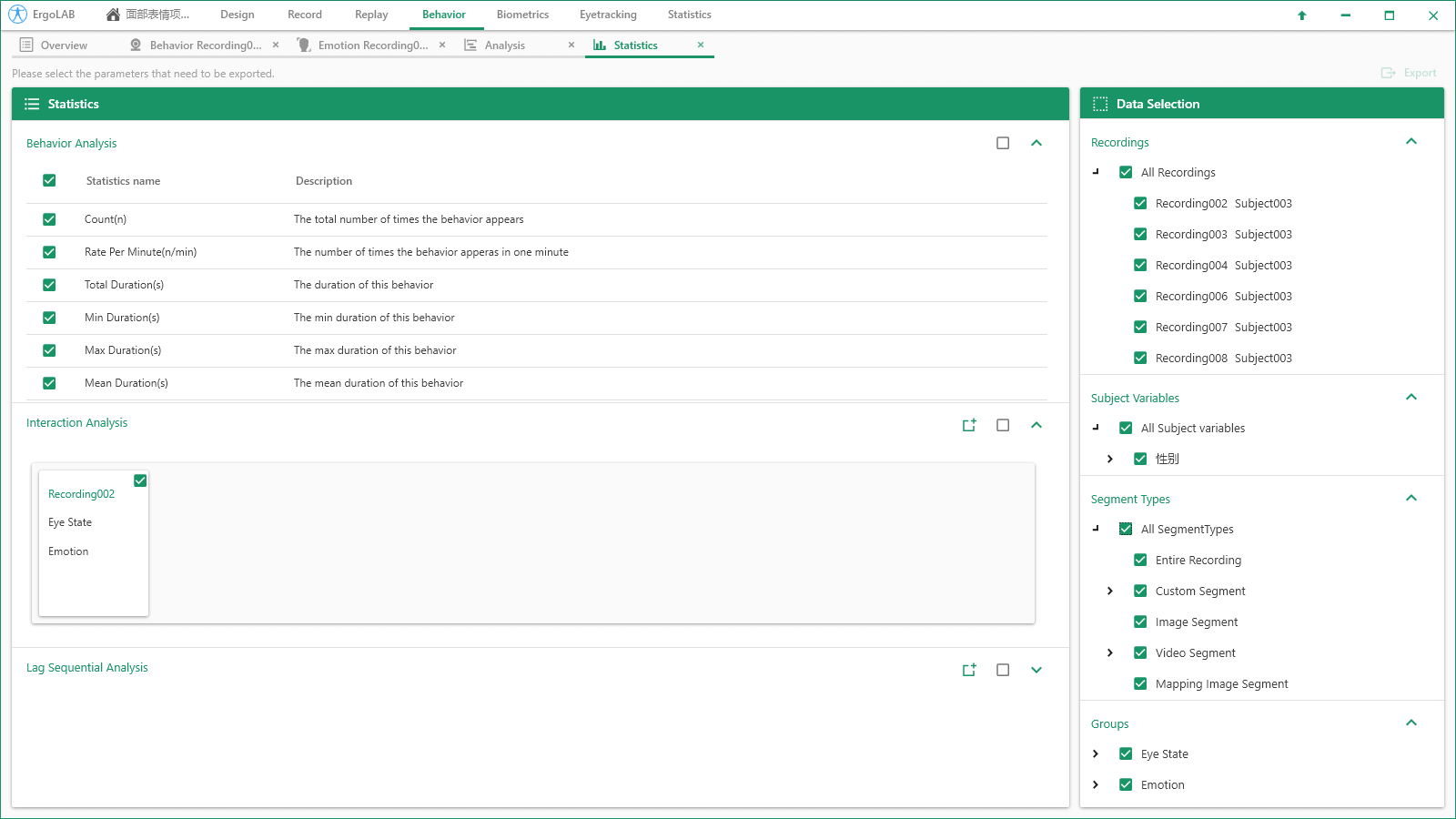

簡要描述:ErgoLAB Emotion面部表情分析模塊,是一款專業(yè)的面部表情分析與狀態(tài)識別工具。系統(tǒng)結(jié)合機器學習算法與圖像識別技術(shù),利用面部肌肉特征點計算和分類表情狀態(tài),自動編碼多種基本表情、精確計算情感效價,系統(tǒng)可實時檢測被試的頭部位置、面部特征點、視線朝向、基本生物信息等,結(jié)合AI狀態(tài)識別進一步實現(xiàn)對操作人員的分心、疲勞、應激等狀態(tài)的自動識別以及特定環(huán)境條件下的預警反饋。

產(chǎn)品型號:

產(chǎn)品型號: 廠商性質(zhì):生產(chǎn)廠家

廠商性質(zhì):生產(chǎn)廠家 更新時間:2025-05-12

更新時間:2025-05-12 訪 問 量:1454

訪 問 量:1454產(chǎn)品分類

Product Category相關(guān)文章

Related Articles詳細介紹

| 品牌 | 津發(fā)科技 | 適用領(lǐng)域 | 科研 |

|---|---|---|---|

| 產(chǎn)地 | 國產(chǎn) | 加工定制 | 否 |

人機工程、人的失誤與系統(tǒng)安全、人機工效學、工作場所與工效學負荷等

從安全的角度和著眼點,運用人機工程學的原理和方法去解決人機結(jié)合面安全問題

人-車-路-環(huán)境系統(tǒng)的整體研究,有助于改善駕駛系統(tǒng)設(shè)計、提高駕駛安全性、改善道路環(huán)境等

ErgoLAB可實現(xiàn)桌面端、移動端以及VR虛擬環(huán)境中的眼動、生理、行為等數(shù)據(jù)的采集,探索產(chǎn)品設(shè)計、人機交互對用戶體驗的影響

研究如何通過城市規(guī)劃與建筑設(shè)計來滿足人的行為心理需求,以創(chuàng)造良好環(huán)境,提高工作效率

通過ErgoLAB采集和分析消費者的生理、表情、行為等數(shù)據(jù),了解消費者的認知加工與決策行為,找到消費者行為動機,從而產(chǎn)生恰當?shù)臓I銷策略使消費者產(chǎn)生留言意向及留言行為

掃一掃,關(guān)注微信

掃一掃,關(guān)注微信

郵箱:sales@kingfar.cn

電話:4008113950